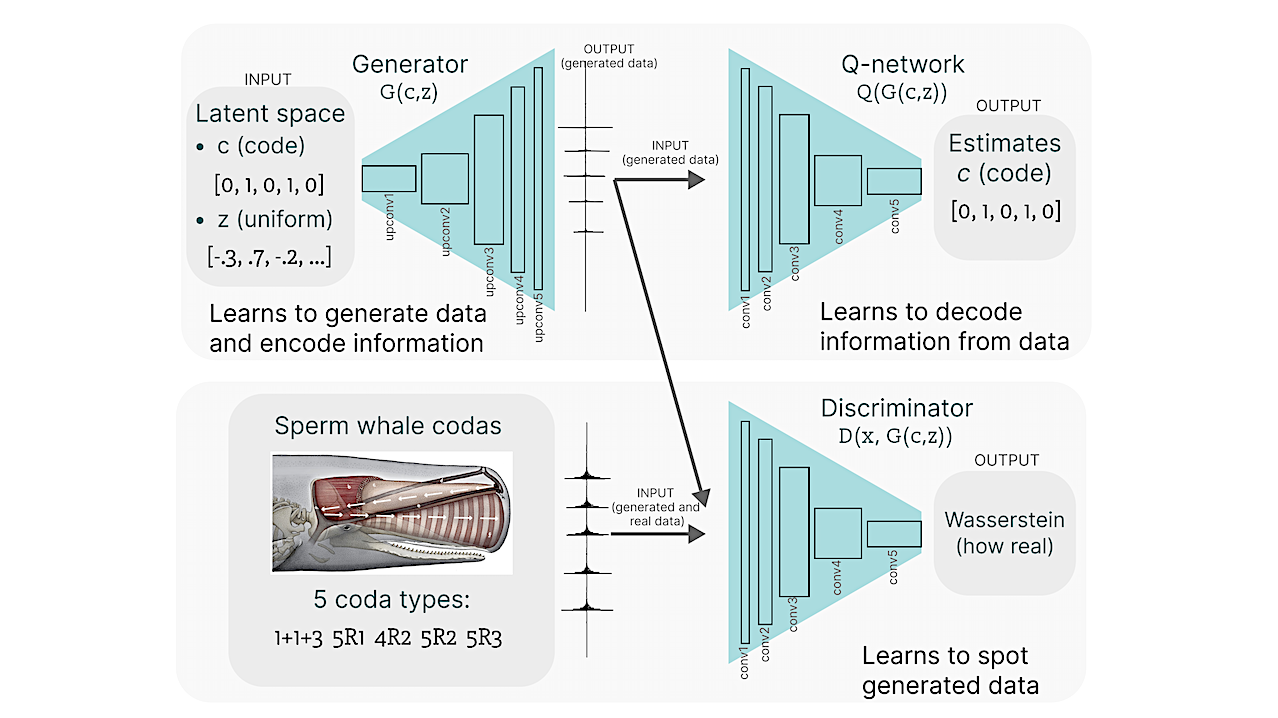

Descripción general de la arquitectura fiwGAN (Beguš, 2021b) y datos utilizados para el entrenamiento. La figura muestra tres redes: el generador con 5 capas convolucionales, la red Q con 5 capas convolucionales y la red discriminadora con 5 capas convolucionales. -stat.ML

Este artículo propone una metodología para descubrir propiedades significativas en los datos mediante la exploración del espacio latente de modelos generativos profundos no supervisados. Combinamos el tratamiento de variables latentes individuales y valores atípicos fuera del dominio de entrenamiento con métodos inspirados en la inferencia causal en un enfoque que llamamos descomposición causal con valores atípicos (CDEV) y mostramos que este enfoque proporciona información sobre la interpretabilidad del modelo. Usando esta técnica, podemos inferir propiedades de datos desconocidos que el modelo codifica como significativos.

Aplicamos la metodología para probar qué tiene de significativo el sistema de comunicación de los cachalotes, uno de los sistemas de comunicación animal más interesantes y aún por estudiar. Entrenamos una red que se ha demostrado que aprende representaciones significativas del habla y probamos si podemos aprovechar este aprendizaje no supervisado para descifrar las propiedades de otro sistema de comunicación vocal sobre el cual no tenemos una verdad fundamental.

La técnica propuesta sugiere que los cachalotes codifican información utilizando el número de clics en una secuencia, la regularidad de su sincronización y propiedades acústicas como el promedio espectral y la regularidad acústica de las secuencias. Algunos de estos hallazgos son consistentes con hipótesis existentes, mientras que otros se proponen por primera vez.

También vemos que nuestros modelos revelan las reglas que gobiernan la estructura de las unidades de comunicación en el sistema de comunicación del cachalote y las aplican mientras generan datos novedosos que no aparecen durante el entrenamiento.

Este artículo sugiere que interpretar el resultado de las redes neuronales profundas utilizando una metodología causal puede ser una estrategia viable para tratar con datos sobre los que se sabe poco, y proporciona otro caso de cómo el aprendizaje profundo puede limitar el espacio de hipótesis.

Finalmente, el enfoque propuesto que combina manipulación del espacio latente e inferencia causal puede extenderse a otros constructos y conjuntos de datos aleatorios.

Gaspar Bigos, André Lepin, Shane Giroux

Comentarios: 25 páginas, 23 números

Temas: Aprendizaje automático (stat.ML); Aprendizaje automático (cs.LG); audio(cs.SD); Procesamiento de audio y voz (eess.AS)

Citar como: arXiv:2303.10931 [stat.ML] (O arXiv:2303.10931v1 [stat.ML] para esta versión)

https://doi.org/10.48550/arXiv.2303.10931

Enfócate para aprender más

Día de entrega

De: André Líbano

[v1] Lunes 20 de marzo de 2023, 08:09:13 UTC (8148 KB)

https://arxiv.org/abs/2303.10931

Astrobiología, SETI, CETI,

«Organizador. Escritor. Nerd malvado del café. Evangelista general de la comida. Fanático de la cerveza de toda la vida.